Langchain的入门使用

2024/11/4...大约 1 分钟

Langchain的入门使用

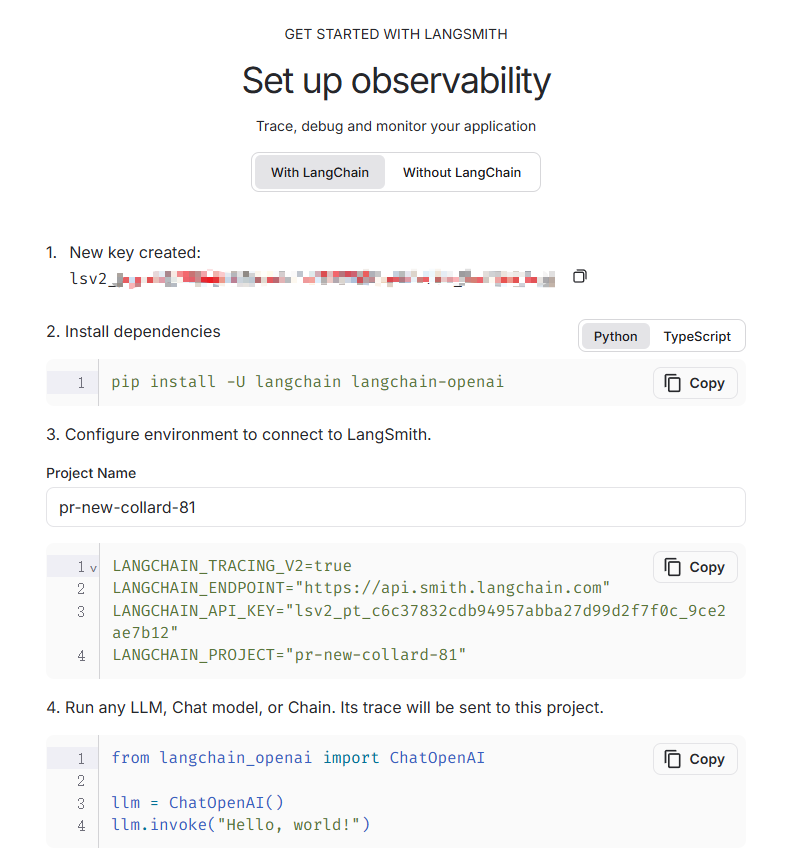

安装Langchain

pip install langchain

pip install langchain-openai本地创建环境 .env ,将OpenAI API密钥保存在.env文件中

pip install python-dotenvOPENAI_API_KEY=your_api_keyfrom langchain_openai import ChatOpenAI

# model_name 或 mode 都行

model = ChatOpenAI(openai_api_key = os.environ['OPENAI_API_KEY_ALI'],model_name = 'qwen-turbo', openai_api_base = os.environ['OPENAI_API_BASE'])

model如果您不想设置环境变量,则可以在启动 OpenAI LLM 类时直接通过命名参数传入密钥:openai_api_key

model = ChatOpenAI(openai_api_key="...")调用

model.invoke("Hello, world!")

# 得到响应

AIMessage(content='你好,世界!这是一个经典的编程问候语。你想要了解一些什么内容呢?', additional_kwargs={'refusal': None}, response_metadata={'token_usage': {'completion_tokens': 18, 'prompt_tokens': 22, 'total_tokens': 40, 'completion_tokens_details': None, 'prompt_tokens_details': None}, 'model_name': 'qwen-turbo', 'system_fingerprint': None, 'finish_reason': 'stop', 'logprobs': None}, id='run-c6b60530-e54a-4d66-882e-005d44fa310d-0', usage_metadata={'input_tokens': 22, 'output_tokens': 18, 'total_tokens': 40, 'input_token_details': {}, 'output_token_details': {}})解析

首先导入 simple output 解析器

from langchain_core.output_parsers import StrOutputParser

parser = StrOutputParser()单独调用:

parser.invoke(result)更常见的是,我们可以用这个 output parser 来 “链接” 模型。这意味着此 output parser 将在此链中每次被调用。此链采用语言模型的 input 类型(字符串或消息列表),并返回输出解析器的输出类型(string)。

我们可以使用 | 运算符轻松创建链。在 LangChain 中使用 | 运算符将两个元素组合在一起。

chain = model | parser

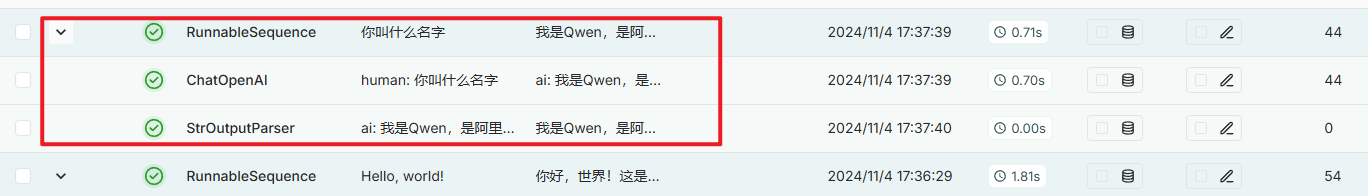

chain.invoke("你叫什么名字")看一下 LangSmith,我们可以看到链有两个步骤:首先调用语言模型,然后将结果传递给输出解析器。